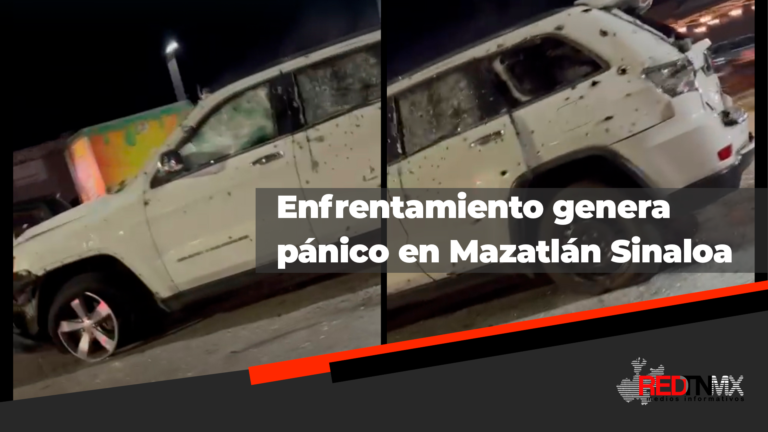

La balacera en Mazatlán ocurrida en el centro comercial Plaza Acaya ha generado un ambiente de tensión y preocupación en la ciudad. La noche del domingo, personas que se encontraban en el supermercado Soriana y en otros comercios de la plaza vivieron momentos de pánico cuando sujetos armados persiguieron y atacaron a una camioneta en una violenta persecución. Los clientes y empleados de la plaza se vieron obligados a refugiarse y a bajar las cortinas de los locales, mientras la balacera se prolongaba en los alrededores.

Hasta el momento, las autoridades locales no han emitido un reporte oficial sobre heridos o fallecidos, aunque las imágenes en redes sociales muestran la magnitud del incidente y el miedo de quienes estuvieron presentes. La situación ha desencadenado un debate sobre la seguridad en Mazatlán, una ciudad turística que ha experimentado episodios de violencia en diversas áreas públicas.